Bayer-Sensor

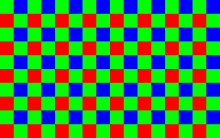

Als Bayer-Sensor bezeichnet man einen Fotosensor, der – ähnlich einem Schachbrett – mit einem Farbfilter überzogen ist, welcher meist zu 50 % aus Grün und je 25 % aus Rot und Blau besteht. Grün ist in der Flächenzuweisung und somit in der Auflösungsfähigkeit privilegiert, weil der Grün-Anteil in Grautönen beim menschlichen Auge den größten Beitrag zur Helligkeitswahrnehmung und somit auch zur Kontrast-Wahrnehmung und Schärfe-Wahrnehmung leistet: 72 % der Helligkeits- und Kontrastwahrnehmung von Grautönen wird durch deren Grünanteil verursacht, dagegen leistet Rot nur 21 % und Blau nur 7 %. Zudem ist Grün, als die mittlere Farbe im Farbspektrum, diejenige, für die Objektive in der Regel die höchste Schärfe und Auflösung liefern.

Nach diesem Konzept der Bayer-Matrix arbeiten fast alle gebräuchlichen Bildsensoren in digitalen Fotokameras und Filmkameras. Das Konzept dieses Sensortyps steht im Gegensatz zum Konzept der Foveon-X3-Direktbildsensoren.

Die „Bayer-Matrix“ oder „Bayer-Filter“ ist nach ihrem Erfinder Bryce E. Bayer benannt,

der am 5. März 1975 das Patent

im Namen der Eastman

Kodak Company in den USA einreichte (Patent ![]() US3971065: Color imaging array.

US3971065: Color imaging array.

Funktionsweise

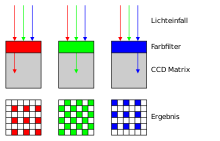

Die lichtempfindlichen Zellen einer einzelnen Photozelle auf dem Halbleiter können nur Helligkeitswerte (Schwarz, Graustufen und Weiß) erfassen. Um Farbinformationen zu erhalten, wird vor jeder einzelnen Zelle ein winziger Farbfilter in einer der drei Grundfarben Rot, Grün oder Blau aufgebracht. Die Filter sind beispielsweise in den ungeraden Zeilen in der Folge Grün-Rot und in den geraden Zeilen in der Folge Blau-Grün aufgebracht. Jeder Farbpunkt (Pixel) liefert entsprechend nur Informationen für eine einzige Farbkomponente an dieser Stelle, so dass für ein vollständiges Bild mit denselben Abmessungen die jeweils benachbarten Pixel derselben Farbe zur Farbinterpolation herangezogen werden müssen. Für Grün werden somit 50 % der Pixel errechnet, bei Blau und Rot sind es jeweils 75 % der Fläche (oder in einer Zeile 50 % und in der Folgezeile 100 % der Zeile), die durch Berechnung gefüllt werden müssen. Bei der Farbinterpolation geht man davon aus, dass es im Bild zwischen zwei benachbarten Pixeln gleicher Farbe nur zu geringen Farbunterschieden kommt und somit die Grauwerte der Pixel stochastisch nicht unabhängig voneinander sind. Das muss natürlich nicht auf jedes Bildmotiv zutreffen. Daher besitzt der Bayer-Sensor unter der Betrachtung eines artefaktfreien Bildes streng genommen nur ein Viertel der scheinbaren Auflösung.

Solche Sensoren haben außerdem fast immer weitere Pixel, die sich am Rand der Sensorfläche befinden und in der Regel geschwärzt sind, um damit auch während des Betriebs unter Belichtung das temperaturabhängige Grundrauschen des Sensors bestimmen und rechentechnisch berücksichtigen zu können, also z.B. zur Berechnung eines Ausgleichswerts für die Auswertung der anderen Pixel. Darüber hinaus lassen sich diese Pixel aber auch z.B. zur Erkennung extremer Überbelichtung, etwa durch zu lange Belichtungszeit der Sensorelemente, verwenden. Für den normalen Kameraanwender jedoch sind sie ohne Bedeutung, da der Abgleichvorgang automatisch abläuft und je nach Modell gegebenenfalls schon direkt auf dem Sensor realisiert wird.

Zu diesem Zweck könnten drei separate Sensoren in Verbindung mit einem Strahlteiler verwendet werden, um jede der drei Grundfarben an jedem Pixel genau zu messen. Dieser Ansatz ist jedoch teuer und mechanisch schwierig zu implementieren. Um dieses Hindernis zu überwinden, wurde das Farbfilterarray eingeführt, um ein Farbbild mit nur einem Sensor aufzunehmen. Ein Farbfilterarray ist eine Anordnung alternierender Farbfilter, die an jedem Pixelort nur eine Farbe abtasten.

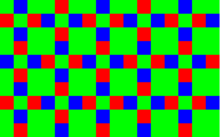

Der Bayer-Sensor enthält blaue und rote Filter an abwechselnden Positionen in horizontaler und vertikaler Richtung sowie grüne Filter an den verbleibenden Positionen (siehe Abbildung). Dieses Muster führt dazu, dass die Hälfte der Bildauflösung für die genaue Messung des grünen Farbbandes verwendet wird. Die größte Empfindlichkeit des menschlichen visuellen Systems liegt bei den mittleren Wellenlängen des sichtbaren Lichts, was die zusätzlichen grünen Filter rechtfertigt. Weil für jedes Pixel nur noch eine Farbe abgetastet wird, müssen die fehlenden Informationen wiederhergestellt werden. Zu diesem Zweck gibt es verschiedene Algorithmen, die von einfacher linearer Interpolation bis zu nichtlinearer Interpolation reichen, die so viele räumliche und spektrale Informationen wie möglich nutzen. Demosaicing ist der Prozess, durch den drei vollständig ausgefüllte Farbebenen aus den Daten des Farbfilterarrays erstellt werden.

Interpolation

Die erwähnte Interpolation (englisch: Demosaicing) kann auf verschiedene Arten durchgeführt werden. Einfache Verfahren interpolieren den Farbwert aus den Pixeln gleicher Farbe in der Nachbarschaft. Da dieses Vorgehen vor allem senkrecht zu Kanten problematisch ist, versuchen andere Verfahren, die Interpolation gerade bevorzugt entlang von Kanten, anstatt senkrecht dazu, durchzuführen. Wieder andere Algorithmen beruhen auf der Annahme, dass der Farbton einer Fläche im Bild auch bei sich ändernden Lichtverhältnissen relativ konstant ist, wodurch die Farbkanäle dann stark miteinander korrelieren. Daher wird zuerst der grüne Kanal interpoliert, um danach den roten und den blauen Kanal so zu interpolieren, dass die jeweiligen Farbverhältnisse Rot-Grün beziehungsweise Blau-Grün konstant sind. Es existieren noch weitere Verfahren, die andere Annahmen über den Bildinhalt machen und von diesen ausgehend versuchen, die fehlenden Farbwerte zu berechnen. Mit 5×5-Matrixfiltern wird z.B. ein geglättetes Bild erzeugt, das anschließend nochmals geschärft wird.

Bildfehler – oft als Interpolationsartefakte bezeichnet – können entstehen, wenn die vom Algorithmus getroffenen Annahmen in einer konkreten Aufnahme verletzt sind. Beispielsweise trifft die oben genannte, von vielen höheren Algorithmen ausgenutzte Annahme, dass die Farbebenen korrelieren, nicht mehr zu, wenn aufgrund von chromatischen Aberrationen handelsüblicher Objektive die Farbebenen in den Randbereichen gegeneinander verschoben sind.

Ein weiteres Problem sind Streifenmuster mit einer Streifenbreite entsprechend ca. der eines einzelnen Pixels, beispielsweise ein Lattenzaun in einer passenden Entfernung. Da ein durch ein solches Motiv erzeugtes Bayer-Rohbild-Muster sowohl durch horizontale als auch durch vertikale Lattenzäune (unterschiedlicher Farben) erzeugt worden sein könnte, muss der Algorithmus eine Entscheidung treffen, ob es sich um eine horizontale oder eine vertikale Struktur handelt, und welche Farbkombinationen als wie plausibel bewertet werden sollen. Da der Algorithmus nicht über menschliches Motiv-Weltwissen verfügt, kommt es dann oft zu zufälligen Entscheidungen, somit zu Fehlentscheidungen. Beispielsweise kann ein solcher Lattenzaun dann fälschlich als eine zufällige Mischung von horizontalen und vertikalen Abschnitten, somit ähnlich wie ein Labyrinth, verkehrt dargestellt werden.

Gegeben sei z.B. ein Motiv-Ausschnitt, innerhalb dessen alle roten Pixel leuchten und von den grünen nur diejenigen in den roten Spalten. Zu dieser Abbildung würden folgende Motive gleichermaßen passen:

- ein vertikaler Lattenzaun mit weißen Latten vor schwarzem Hintergrund

- ein vertikaler Lattenzaun mit gelben Latten vor schwarzem Hintergrund

- ein vertikaler Lattenzaun mit weißen Latten vor rotem Hintergrund

- ein vertikaler Lattenzaun mit gelben Latten vor rotem Hintergrund

- ein horizontaler Lattenzaun mit roten Latten vor grünem Hintergrund

- ein horizontaler Lattenzaun mit roten Latten vor gelbem Hintergrund

- ein horizontaler Lattenzaun mit violetten Latten vor grünem Hintergrund

- ein horizontaler Lattenzaun mit violetten Latten vor gelbem Hintergrund

- sowie alle denkbaren Lattenzaun- oder Gitter-Motive, die eine beliebige Mischung aus den obengenannten Möglichkeiten sind.

In diesem einfachen theoretischen Beispiel könnte ein Algorithmus z.B. die Variante mit der geringsten Gesamt-Farbigkeit bevorzugen, somit vertikale weiße Latten vor schwarzem Hintergrund annehmen. In der Praxis stimmen die Struktur-Ausrichtungen jedoch kaum exakt mit dem Bayer-Raster überein, so dass bei einem solchen Lattenzaun-Motiv keine Schwarz-Weiß-Option zur Auswahl stünde, sondern mehrere Alternativen mit ähnlicher Farbigkeits-Plausibilität um den Vorzug konkurrieren, und es zu Zufallsentscheidungen kommt.

Diese Probleme werden allerdings umso mehr abgemildert, als die Auflösung moderner Sensoren die Auflösung der Objektive erreicht oder sogar übersteigt, insbesondere bei Zoom-Objektiven, oder Objektiven der unteren Preisklasse. Da die Auflösungsgrenze von Objektiven (im Gegensatz zu Sensoren) nicht festgelegt, sondern als eine Kontrastgrenze definiert ist, bedeutet das, dass fein detaillierte Motivausschnitte mit einer hohen Artefakt-Neigung von solchen Objektiven nur noch mit einem sehr geringen Kontrast auf dem Sensor abgebildet werden können. Somit haben auch Interpolationsartefakte solcher Motivausschnitte einen sehr geringen Kontrast und wirken sich weniger störend aus.

Bearbeitungsbeispiel

Ein Beispiel einer Bayer-Bild-Rekonstruktion mit Software. Die Bilder sind der Darstellung wegen um den Faktor 10 vergrößert dargestellt.

-

Original-Sensorbild (Helligkeitsinformation in Schwarz-Weiß)

Original-Sensorbild (Helligkeitsinformation in Schwarz-Weiß) -

SW-Sensorbild mit virtuellem Farbfilter überlagert

SW-Sensorbild mit virtuellem Farbfilter überlagert -

Vorverarbeitetes Bild mittels Software-Filter

Vorverarbeitetes Bild mittels Software-Filter -

Vollständig bearbeitetes Bild inklusive Rekonstruktion

Vollständig bearbeitetes Bild inklusive Rekonstruktion

Alternative Entwicklungen

Kodak hat mit verschiedensten Pixelanordnungen mit zusätzlichen „weißen“ Pixeln experimentiert. Auch Sony hatte bei einigen Modellen „weiße“ Pixel eingebaut und zum Beispiel 2003 bei der Sony DSC-F 828 einen Bildsensor mit zwei Grüntönen verwendet (RGEB = red (rot) / green (grün) / emerald (smaragdgrün) / blue (blau)).

Des Weiteren wurde eine Bayer-Variante entwickelt, bei der die beiden Grün-Pixel eines 2×2-Blocks jeweils unterschiedliche Farbfilter (für leicht unterschiedliche Grüntöne) hatten. Diese Variante wurde beispielsweise in der Canon EOS 7D und von anderen Herstellern zeitweise verbaut.

Einen anderen Ansatz hat Fujifilm mit seiner 2012 auf den Markt gebrachten Kamera Fujifilm X-Pro1 vorgestellt: Die RGB-Pixel wurden in einem anderen Verhältnis (22 %/56 %/22 % statt 25 %/50 %/25 %) und einer anderen Anordnung (XTrans) auf dem Sensor verteilt, die Elementarzelle (nach der sich das Muster wiederholt) vergrößert sich von 2 × 2 auf 6 × 6 Pixel, und jede Pixelfarbe kommt in jeder Zeile und jeder Spalte vor. Da rote und blaue Pixel nun nicht mehr genau 2, sondern im Durchschnitt 2,23 Längeneinheiten von ihrem nächsten gleichfarbigen Nachbarn entfernt sind, ist die Auflösung der Rot- und Blau-Ebene dabei allerdings um etwa zehn Prozent reduziert, paradoxerweise aber auch die grüne Auflösung. Denn jedes grüne Pixel innerhalb eines grünen 2×2-Quadrates hat hier zwar weiterhin, wie beim Bayer-Muster, stets genau vier grüne Nachbarn, allerdings nun ungleichmäßig verteilt: zwei nähere und zwei fernere.

Da die mathematischen Forschungen zu Farbmuster-Interpolations-Algorithmen regelmäßig von einem klassischen Bayer-Muster ausgehen, können solche alternativen Farbmuster-Ideen von der Qualität neuerer algorithmischer Ansätze häufig nicht hinreichend profitieren und sind demzufolge in der Qualität der Umsetzung in ein Vollfarbbild durch Rohbild-Konvertierungs-Software benachteiligt.

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 28.11. 2023