Bedingte Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit (auch konditionale

Wahrscheinlichkeit) ist die Wahrscheinlichkeit

des Eintretens eines Ereignisses

unter der Bedingung, dass das Eintreten eines anderen Ereignisses

bereits bekannt ist. Sie wird als

geschrieben. Der senkrechte Strich ist als „unter der Bedingung“ zu lesen und

wie folgt zu verstehen: Wenn das Ereignis

eingetreten ist, beschränken sich die Möglichkeiten auf die Ergebnisse in

.

Damit ändert sich auch die Wahrscheinlichkeit; diese neue Wahrscheinlichkeit für

das Ereignis

ist gegeben durch

.

Die bedingte Wahrscheinlichkeit kann also als Neueinschätzung der

Wahrscheinlichkeit von

interpretiert werden, wenn die Information vorliegt, dass das Ereignis

bereits eingetreten ist. Manchmal wird auch die Schreibweise

verwendet, die jedoch auch andere Bedeutungen haben kann.

Für einen verallgemeinerten, abstrakten Begriff von bedingten Wahrscheinlichkeiten siehe bedingter Erwartungswert.

Motivation und Definition

Mitunter möchte man untersuchen, wie stark der statistische Einfluss einer

Größe auf eine andere ist. Beispielsweise möchte man wissen, ob Rauchen ()

krebserregend (

)

ist. Die logische Implikation

würde fordern, dass der Schluss

für alle Instanzen gilt, dass also jeder Raucher an Krebs erkrankt. Ein einziger

Raucher, der keinen Krebs bekommt, würde die Aussage „Rauchen ruft mit logischer

Sicherheit Krebs hervor“ beziehungsweise „Jeder Raucher bekommt Krebs“

falsifizieren. Dennoch, obwohl es Raucher ohne Krebs gibt, besteht ein

statistischer Zusammenhang zwischen diesen beiden Ereignissen: Die

Wahrscheinlichkeit, an Krebs zu erkranken, ist bei Rauchern erhöht. Diese

Wahrscheinlichkeit ist die bedingte Wahrscheinlichkeit

,

dass jemand Krebs bekommt, unter der Bedingung, dass er Raucher ist.

Stochastisch kann nun ebenso die Wahrscheinlichkeit untersucht werden, dass

jemand raucht, unter der Bedingung, dass er Krebs hat. In der

Wahrscheinlichkeitsrechnung ist somit zu beachten, dass der Begriff der

Bedingung nicht an einen kausalen

oder zeitlichen Zusammenhang gebunden ist. Die bedingte Wahrscheinlichkeit gibt

ein Maß dafür an, wie stark der statistische Einfluss von

auf

ist. Sie kann als stochastisches Maß dafür angesehen werden, wie wahrscheinlich

der Schluss

ist. Sie sagt aber, wie alle statistischen Größen, nichts über die etwaige

Kausalität des Zusammenhangs aus.

Mit dieser Motivation kommt man zu folgender Definition:

Wenn

und

beliebige Ereignisse sind und

ist, dann ist die bedingte Wahrscheinlichkeit von

,

vorausgesetzt

(auch die Wahrscheinlichkeit von

unter der Bedingung

),

notiert als

(mit senkrechtem Strich zwischen A und B), definiert durch:

Darin ist

die Wahrscheinlichkeit, dass

und

gemeinsam auftreten.

wird gemeinsame Wahrscheinlichkeit, Verbundwahrscheinlichkeit oder

Schnittwahrscheinlichkeit genannt.

bezeichnet dabei den mengentheoretischen

Schnitt der Ereignisse

und

.

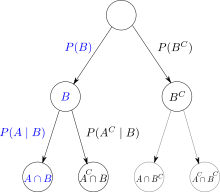

Multiplikationssatz

Durch Umformen der Definitionsformel entsteht der Multiplikationssatz für zwei Ereignisse:

Verallgemeinert man den obigen Ausdruck des Multiplikationssatzes, der für

zwei Ereignisse gilt, erhält man den allgemeinen Multiplikationssatz. Man

betrachte dazu den Fall mit

Zufallsereignissen

.

Besonders anschaulich ist hier das Rechnen mit einem Entscheidungsbaum, da hier das Diagramm gleichsam „mitrechnet“: Die Daten sind leicht einzusetzen und führen sequenziell an den richtigen Rechengang heran.

Gesetz der totalen Wahrscheinlichkeit

Sind nur bedingte Wahrscheinlichkeiten und die Wahrscheinlichkeiten des

bedingenden Ereignisses bekannt, ergibt sich die totale Wahrscheinlichkeit von

aus

wobei

das Gegenereignis

zu

bezeichnet.

Auch hier gibt es eine Verallgemeinerung. Gegeben seien Ereignisse

mit

für alle

,

die eine Partition

des Wahrscheinlichkeitsraums

bilden, d.h., sie sind paarweise disjunkt

und

.

Dann gilt:

.

Stochastische Unabhängigkeit

Wenn

und

stochastisch

unabhängig sind, gilt:

,

was dann zu Folgendem führt:

bzw.

.

Anders gesagt: Egal, ob das Ereignis B stattgefunden oder nicht stattgefunden hat, ist die Wahrscheinlichkeit des Ereignisses A stets dieselbe.

Satz von Bayes

Für den Zusammenhang zwischen

und

ergibt sich direkt aus der Definition und dem Multiplikationssatz der Satz von Bayes:

.

Dabei kann

im Nenner mit Hilfe des Gesetzes der totalen Wahrscheinlichkeit berechnet

werden.

Stetige Zufallsvariable

Für zwei Zufallsvariablen

,

mit gemeinsamer

Dichte

ist eine Dichte

von

gegeben durch

.

Falls ,

kann man eine bedingte

Dichte

von

,

gegeben (oder vorausgesetzt) das Ereignis

,

definieren durch

.

Statt

schreibt man auch

,

für die bedingte Dichte. Die letztere Formel soll aber nicht verstanden werden

wie die Dichte einer Zufallsvariable

.

Die (eine) simultane Dichte von

und

erhält man dann aus der Formel

.

Daraus lässt sich eine Form des Gesetzes der totalen Wahrscheinlichkeit herleiten:

Dieser Vorgang wird als Marginalisierung bezeichnet.

Hierbei ist zu beachten, dass standardmäßig Dichten,

die die gleichen Integralwerte liefern, dieselbe Wahrscheinlichkeitsverteilung

repräsentieren. Dichten sind daher nicht eindeutig festgelegt. Eine zulässige

Wahl für ,

,

und

ist jede messbare

Funktion, die im Integral die korrekten Wahrscheinlichkeiten für

,

bzw.

für beliebige

,

ergibt. Die Funktion

muss

erfüllen. Die oben angegebenen Formeln gelten somit nur bei passender Wahl der verschiedenen Dichten.

Beispiele

Je nach dem Grad der Überlappung von zwei Ereignissen

und

,

also der Größe der Schnittmenge

,

kann der Eintritt von Ereignis

die Wahrscheinlichkeit, dass auch Ereignis

eingetreten ist, erhöhen oder verringern, und zwar bis auf 1 (

ist fast

sicher eingetreten) oder bis auf 0 (

ist fast sicher nicht eingetreten).

Beispiele mit Würfeln

Die nachstehenden Beispiele beziehen sich immer auf Würfe mit einem fairen

Standardwürfel. Dabei bezeichnet die Schreibweise

ein Ereignis

,

dass bei einem Wurf eine Eins, eine Zwei oder eine Drei gewürfelt wurde.

Sonderfälle

und

haben keine gemeinsamen Elemente. Wenn

eintritt, kann

daher nicht mehr eintreten und umgekehrt.

- Beispiel:

- Ereignis

Ereignis

Wenn

eintritt (also eine Vier, eine Fünf oder eine Sechs gewürfelt wird), ist

sicher nicht mehr möglich.

.

- Das Ereignis

ist eine Teilmenge des Ereignisses

.

- Beispiel:

- Ereignis

Ereignis

.

- Die Wahrscheinlichkeit von

(hier a priori

) erhöht sich in diesem Fall umgekehrt proportional zur Wahrscheinlichkeit von

(hier

, die Wahrscheinlichkeit erhöht sich hier also um den Faktor 2).

- Zur Berechnung der bedingten Wahrscheinlichkeit von

unter der Bedingung

genügt in diesem Fall also die Kenntnis der absoluten Wahrscheinlichkeiten

und

. Die exakte Größe der Schnittmenge

muss nicht bekannt sein.

- Das Ereignis

ist eine Obermenge des Ereignisses

bzw. das Ereignis

ist eine Teilmenge des Ereignisses

.

- Beispiel:

Wenn

eingetreten ist, muss daher

auch eingetreten sein.

.

Allgemeiner Fall

Allgemeiner benötigt man im Laplace-Experiment

zur Berechnung der bedingten Wahrscheinlichkeit von

unter der Bedingung

die Anzahl der Elemente der Schnittmenge

Das Ereignis ,

mindestens eine Vier (d.h. 4 oder höher) zu werfen, hat a priori die

Wahrscheinlichkeit

.

Wenn nun bekannt ist, dass eine gerade Zahl gewürfelt wurde, dass also das

Ereignis

eingetreten ist, dann ergibt sich die bedingte Wahrscheinlichkeit für

unter der Bedingung

wegen

zu

.

Die bedingte Wahrscheinlichkeit ist in diesem Fall höher als die Ausgangswahrscheinlichkeit.

Wenn eine ungerade Zahl gewürfelt wurde, also das Ereignis

eingetreten ist, ist die bedingte Wahrscheinlichkeit für

unter der Bedingung

wegen

gleich

.

Die bedingte Wahrscheinlichkeit ist in diesem Fall kleiner als die A-priori-Wahrscheinlichkeit.

Das Ereignis

hat a priori die Wahrscheinlichkeit

.

Wenn wir wissen, dass das Ereignis

eingetreten ist, verändert sich die Wahrscheinlichkeit für

wegen

auf

.

Auch in diesem Beispiel wird das Ereignis

durch das Eintreten des Ereignisses

unwahrscheinlicher, d.h., die Wahrscheinlichkeit, dass durch den Wurf das

Ereignis

eingetreten ist, ist gegenüber der A-priori-Wahrscheinlichkeit kleiner geworden,

weil durch den Wurf das Ereignis

jedenfalls eingetreten ist.

Wurfmaschine[Bearbeiten | Quelltext bearbeiten]

Ein anschauliches Beispiel erlaubt es, bedingte Wahrscheinlichkeiten anhand

von Mengendiagrammen

unmittelbar zu verstehen. Betrachtet wird eine Wurfmaschine, die in zufälliger

Weise irgendwelche Objekte (z.B. Bälle, Dartpfeile) auf eine bestimmte

Fläche

(z.B. eine Wand) wirft, so dass jeder Ort der Wand mit gleicher

Wahrscheinlichkeit getroffen wird. Die Funktion

ordnet der Fläche

bzw. einer bestimmten Teilfläche

der Wand (z.B. einem beliebigen mit einem Stift markierten Kreis) ihren

Flächeninhalt

bzw.

zu. Dann ist die Wahrscheinlichkeit

,

dass das Wurfgeschoss in

auftrifft, proportional dem Verhältnis der Teilfläche zur Gesamtfläche, also

.

Nun sei zusätzlich vorausgesetzt, dass das Wurfgeschoss innerhalb einer

anderen Teilfläche

aufgetroffen ist, die mit der Teilfläche

überlappt. Dann ist die Wahrscheinlichkeit

,

dass das Wurfgeschoss in

auftrifft,

.

Die bedingte Wahrscheinlichkeit

,

dass das Geschoss unter der zusätzlichen Voraussetzung auch gleichzeitig

innerhalb der überlappenden Teilfläche

auftrifft, ist proportional dem Flächeninhalt desjenigen Teils der Fläche

,

der auch in

liegt, also dem Flächeninhalt

der Schnittmenge

.

Umgekehrt ist für eine gleich groß ausfallende Schnittmenge

umso weniger wahrscheinlich, dass ein in

auftreffendes Wurfgeschoss auch in

auftrifft, je größer

vorausgesetzt war. Also ist

umgekehrt proportional zu

.

Somit ergibt sich die Wahrscheinlichkeit eines Auftreffens in

bei zusätzlich vorausgesetztem Auftreffen in

als bedingte Wahrscheinlichkeit

,

also definitionsgemäß.

Weitere Beispiele

- Beispielsweise ist die bedingte Wahrscheinlichkeit P(„die Erde ist nass“ | „es regnet“) (die Erde ist nass, wenn es regnet) meist groß, denn unter der Voraussetzung, dass es zu einem Zeitpunkt regnet, sollte man erwarten, dass die Erde nass wird. Bedingte Wahrscheinlichkeit fragt also nach, wie wahrscheinlich ein Ereignis ist, wenn ich ein anderes bereits kenne. In unserem Beispiel weiß ich, dass es regnet, und frage mich, wie groß die Wahrscheinlichkeit ist, dass die Erde nass ist. Offensichtlich unterscheidet sich die bedingte Wahrscheinlichkeit von der unbedingten.

- Die Wahrscheinlichkeit, dass jemand, der französisch spricht, ein Franzose ist, ist weder gleich groß der Wahrscheinlichkeit, dass jemand, der ein Franzose ist, auch französisch spricht, noch ergänzen sich beide Wahrscheinlichkeiten auf 100 %.

- People v. Collins (1968): In diesem Strafprozess in Kalifornien wurde ein Angeklagter unter anderem deswegen zu Unrecht als Bankräuber verurteilt, weil gemäß Zeugenaussagen der Täter – genau wie der Angeklagte – sowohl einen Bart als auch einen Schnurrbart trug, was als selten angesehen wurde. Wer einen Bart trägt, trägt aber sehr oft auch einen Schnurrbart – das Gericht legte seinem Fehlurteil nicht die bedingten Wahrscheinlichkeiten zugrunde, wie es korrekt gewesen wäre.

- Auslosungen im Sport: Im Jahr 2013 standen zwei deutsche und zwei spanische Mannschaften im Halbfinale der Champions-League. Die Wahrscheinlichkeit, dass in dieser Konstellation ein rein deutsches und ein rein spanisches Halbfinale ausgelost werden, beträgt ein Drittel, nicht etwa fünfzig Prozent. Gesucht ist die Wahrscheinlichkeit, dass als zweiter Verein der zweite deutsche (spanische) Verein gezogen wird, unter der Bedingung, dass als erste Mannschaft ein deutscher (spanischer) Verein aus dem Lostopf gezogen wurde. Wenn aber als erste Mannschaft ein deutscher (spanischer) Verein gezogen wurde, ist nur noch eine von drei in der Lostrommel verbliebenen Mannschaften ebenfalls deutsch (spanisch). Daher ist die gesuchte Wahrscheinlichkeit 1⁄3. Das zeigt sich auch darin, dass in diesem Fall sechs Paarungen möglich sind. Die Option eines rein deutschen (spanischen) Finalspiels steht also zwei anderen Optionen gegenüber.

- Dieser einfache Fall ist auch elementar ohne bedingte Wahrscheinlichkeit lösbar: Jede der vier Mannschaften bekommt mit gleicher Wahrscheinlichkeit eine der drei anderen Mannschaften zugelost. Nur eine dieser drei Mannschaften kommt aus dem gleichen Land. Also beträgt die gesuchte Wahrscheinlichkeit 1⁄3.

Siehe auch

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 21.10. 2019